기획 리포트

Featured Report

[기획] ICT 신기술과 미디어 산업

실감 콘텐츠화되는영상 패러다임

정동훈

(광운대학교 미디어커뮤니케이션학부 교수)

-

5G 상용화에 따른 B2C 킬러콘텐츠로 가장 많이 언급되는 것은 역시 실감 미디어다. 3G로 인해 스마트폰이, 4G로 인해 OTT 서비스가 가능해진 것처럼, 5G 역시 우리가 전혀 상상하지 못한 새로운 경험을 만드는 실감 미디어가 소개될 것이다. 미디어 산업은 늘 변화와 혁신의 연속이다. OTT, 인공지능, 유튜브, 소셜 미디어, 메타버 스 등 미디어 산업이 당면한 새로운 도전 과정에서 우리는 무엇을 준비해야 할까? 영상업계의 패러다임을 바꾸는 게임엔진을 통해 실감 미디어화되는 미디어 업계의 디지털 트랜스포메이션을 살펴본다.

-

1사용자의 감각에 소구하기디지털 트랜스포메이션을 이야기할 때 가장 중요한 요소로 삼는 것은 데이터(Data), 네트워크(Network), 인공지능(AI), 즉 DNA다. DNA에서도 네트워크는 인프라 중 인프라로 가장 근간이 되는 기술이다. 5G는 빠르게(초고속), 실시간(초저지연)으로 대용량 데이터와 모든 사물을 연결(초연결)시키는 4차 산업혁명 핵심 인프라로, 앞으로 우리가 경험할 스마트시티, 자율자동차, 가상현실 등 우리가 상상하는 미래의 혁신 기술은 모두 5G를 전제로 한다(정동훈, 2021a). 3G로 인해 스마트폰이, 4G로 인해 유튜브와 같은 OTT 서비스가 가능해진 것처럼, 5G 역시 우리가 전혀 상상하지 못한 새로운 경험을 만드는 서비스를 가능하게 만들 것이다.

5G 상용화에 따른 킬러콘텐츠로 가장 많이 언급되는 것은 역시 실감 미디어(Immersive media)다. 실감 미디어란 말 그대로 실제로 체험하는 느낌을 주는 미디어, 즉 인간의 감각기관을 통해 실제로 느껴지는 것 같은 경험을 할 수 있는 미디어를 말한다(정동훈, 2017). 실제로는 스마트폰이나 HMD와 같은 미디어를 사용하지만 마치 그냥 현실에서 느끼는 것처럼, 공간과 시간의 제약 없이 사용자가 진짜처럼 느낄 수 있어야 한다. 현실에서는 불가능한 환경이라 하더라도 진짜라고 느낄 수 있어야 실감 미디어라고 할 수 있다.

사실, 실감 미디어는 어느 때고 존재했다. 실감나게 느낀다는 것은 결국 주관적인 경험이기 때문이다. 시집을 읽고 눈물을 흘렸다면 시집도 훌륭한 실감 미디어다. 사춘기 때에는 특히 감정이 예민해지기에 같은 미디어라도 더 감정적으로 느낄 수 있다. 똑같은 미디어를 사용하더라도 개인에 따라 상황에 따라 달라질 수도 있다. 따라서 실감 미디어는 지극히 주관적일 수밖에 없다.

어느 때고 존재했던 실감 미디어지만, 최근 실감 미디어와 실감 콘텐츠를 더욱 강조하는 이유는 진짜 같은 가짜가 실제보다 더 현실같이 구현될 수 있는 환경이 만들어졌기 때문이다. 디지털 기기와 콘텐츠 제작 기술의 발전은 현실과 가상의 경험을 더욱 실감나게 한다.

가령 TV의 경우, 흑백TV에서 컬러TV로, 그 이후로 HDTV, 3DTV, UHDTV로 발전하고, 극장의 경우 3D, 4D, IMAX, 4D IMAX로 발전하는 것이 한 예이다.

여기에서 중요한 것은 ‘실감나다’라는 느낌은 단순히 시각적이거나 청각적인 특정 감각의 극대화가 아닌, 우리가 일상생활에서 경험하는 것처럼 보고, 듣고, 만지며, 냄새를 맡고, 맛보는 종합적인 경험이라는 것이다(정동훈, 2017). 그래서 실감 미디어는 실제 느낌을 극대화할 수 있도록, 특히 인간의 다차원적 감각, 즉 시각, 청각, 촉각, 후각 등에 정보를 전달할 수 있도록 개발되어야 한다. 최근에 실감 미디어를 새삼 강조하는 이유는 바로 기술의 발전이 인간의 다양한 감각을 자극해서 진짜보다 더 진짜 같은 경험을 만들기 때문이다.

예를 들어, 시각적 효과를 위해서는 우리가 실제로 보는 것과 같은 깊이감을 제공함으로써 3차원 효과를 일으켜야 하고, 청각은 360도 스테레오 사운드를 제공해야 한다.

시청각에 멈추는 것이 아니라 촉각과 후각적 경험으로 확대하는 것도 숙제다. 장갑과 수트를 통해 전달되는 촉각적 반응을 경험하게 하고, 상황에 맞는 냄새를 제공해서 실제처럼 느낄 수 있는 환경을 만들어야 한다. 즉, 실감 미디어는 사용자가 미디어를 사용하지만 그것조차 잊을 정도로 실감이 나게 만들어야 하고, 이것을 위해서는 인간의 감각을 최대한 활용함과 동시에 인간이 가진 기본적인 속성을 잘 분석해야 한다. 출처: Somnium Space and TESLASUIT(https://youtu.be/1BJXHMmpsWI)

출처: Somnium Space and TESLASUIT(https://youtu.be/1BJXHMmpsWI)

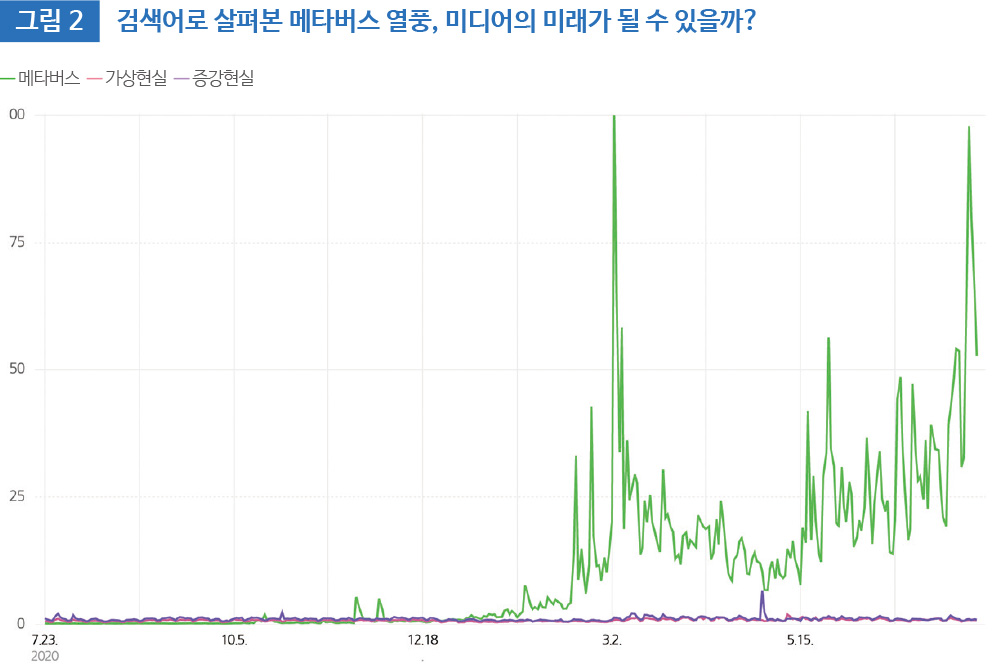

이러한 실감 미디어의 특징 때문에, 최근 메타버스에 대한 지나친 관심은 실감 미디어 연구자로서 걱정과 우려를 하지 않을 수 없게 만든다. 메타버스가 가진 의미는 절대 가볍지 않다. 또한, 궁극적으로 우리의 삶은 현실과 가상의 구분이 모호한 세계관을 가질 것이라는 예측이 그리 어렵지 않다. 다만, 문제는 그리고 핵심은 ‘시간’이다. 언제 그런 일이 벌어질 수 있을 것인가? 한때 3D 산업을 미래 산업으로 예측했고, 포켓몬고 때문에 혼합현실이 금방이라도 거대 산업이 될 것으로 보였다. 가상현실은 어떤가? 마치 내일이라도 가상의 세계가 펼쳐질 것처럼 얘기한 게 벌써 몇 년 전인가?

실감 미디어와 관련하여 메타버스에 대해 우려가 되는 이유다. 그 가능성은 무궁무진하지만, 영화 <레디 플레이어 원(Ready Player One, 2018)>에서 그리는 오아시스가 펼쳐지기 위해서는 너무나 많은 시간이 필요하다. 뉴스나 기업에서 당장에 적용될 것 같이 말하는 기술을 사용자가 기꺼이 사용하기에는 감당하지 못할 큰 장벽이 있다. 몇 가지 사례로 현혹하는 현상에 속지 말고, 당장 사용자 경험을 충족시킬 수 있는 현재의 기술 기반 미디어와 콘텐츠에 더 신경 써야 한다. 출처: 네이버 데이터랩(2021.07.24.)

출처: 네이버 데이터랩(2021.07.24.)

제페토(Zepeto)를 비롯한 메타버스의 대표적 사례를 얘기하는 대부분 플랫폼에서 사용자는 아바타(Avatar)를 통해 존재한다. 아바타를 움직이기 위해 사용자는 스마트폰에서 왼손으로 방향을 조정하고, 오른손으로 점프를 하거나 특정 행동을 한다. 컴퓨터에서는 마우스로 움직이고, 키보드를 조작한다. 적어도 이와 같은 사용자 경험으로 메타버스의 미래를 이야기하기에는 그 수준이 너무 낮다. 헤드마운트디스플레이(Head-Mounted Display: HMD)를 끼고 양손에는 콘트롤러나 촉각(Haptic) 인식 장갑을 끼고 자연스럽게 움직일 수 환경을 제공하지 않는 한, 메타버스를 넥스트 인터넷으로 간주하기에는 사용자 경험이 그리 긍정적이지 않다.

실감 미디어의 시대라고 해서 가상현실과 혼합현실, 홀로그램으로 무엇인가를 만들어야 한다는 생각은 하지 않아도 된다. 메타버스의 시대라고 해서 메타버스의 정의도 내리지 않은 채 제페토나 로블록스(Roblox), 디센트럴랜드(Decentraland)와 같은 무엇인가를 해야 한다는 생각은 필패 전략이다. 사용자는 다양한 이유로 현재의 미디어를 대체하거나 병행한다. 단지 기술의 진보가 사용자를 이끌 것으로 생각하는 것은 다분히 현상만을 보는 편협한 시각이다. 가상현실 기기를 꾸준히 사용해보지도 않고, 오큘러스 퀘스트2(Oculus Quest 2)의 판매량 때문에 가상현실 산업이 곧 주류가 될 것처럼 소개하는 뉴스 기사나, 새로운 기술이 소개되면 언제나 그렇듯 몇몇 독특한 사례 때문에 견강부회(牽强附會)하는 테크 사업자와 언론사의 선동이 야속하다.

기술적 요소가 실감 미디어를 좌우하는 유일한 요소는 아니다. 여전히 스토리텔링이 중요하고, 사용자 경험은 그 무엇보다도 중요하다. 그런 의미에서 실감 미디어 시대에 영상 산업 전반의 플로우를 바꿀 수 있는 기반에 더 관심을 두는 것이 적절할 것이다. 대표적인 예로 리얼타임 렌더링(Real Time Rendering), 즉 게임엔진의 예를 통해 설명하고자 한다. -

2영상 산업의 패러다임이 바뀌다게임엔진은 말 그대로 게임을 만드는 데 사용되는 도구를 말한다(정동훈, 2020). 게임사마다 고유의 게임엔진이 있지만 가장 널리 알려진 것은 언리얼 엔진(Unreal Engine)과 유니티(Unity)다. 먼저 게임엔진의 특징을 살펴보면, 게임엔진은 현실 물리 체계를 그대로 가상에 재현해내는 물리 기반 렌더링을 지원함으로써 정교한 빛의 표현이나 움직임의 표현이 뛰어나다. 예를 들어, 실제 총의 궤적이나 속도를 적용하여 적과의 거리, 속도 등을 고려해 총을 쏴야만 적에게 적중할 수 있을 정도로 정교한 플레이가 가능하다.

또한, 리얼타임 렌더링은 가상현실과 혼합현실이 가져야 하는 즉각적인 상호 작용성을 구현하는 데 적합하다. 기존의 작업은 모두 오프라인 렌더링을 해야 하므로 오랜 시간과 비용이 들었다. 그러나 게임엔진은 리얼타임 렌더링 기술을 사용하므로 실시간 작업이 가능하다. 3D 그래픽을 이용하는 디지털 엔터테인먼트 업계에서는 이것을 혁명으로 받아들일 정도로 대단한 변화다. 게임엔진의 용도는 이미 게임 제작을 넘어섰다. 영상, 디자인, 엔지니어링, 건축 등 시각화가 필요한 모든 분야에 활용되고 있다고 해도 과언이 아니다.

애니메이션으로 유명한 픽사(Pixar)의 최초 VR 영화인 <코코(Coco, 2017)>, <디스트릭트 9(District 9)>의 감독인 닐 블롬캠프(Neill Blomkamp)가 만든 <아담(ADAM, 2017)>은 유니티 엔진으로만 만든 영화다.

이 밖에도 <정글북(Jungle Book, 2016)>, <블레이드 러너 2049(Blade Runner 2049, 2017)>, <레디 플레이어 원> 등도 유니티를 활용해 만들었다. 디즈니플러스에서 개봉해 큰 인기를 얻었던 <만달로리안(Mandalorian, 2019~)>, <한 솔로: 스타워즈 스토리(Solo: A Star Wars Story, 2018)> 등은 언리얼 엔진을 사용했다. 이처럼 영화 산업에서 게임엔진은 이미 주요한 제작 도구로 자리 잡았다.

실감 미디어의 대표적 분야인 가상현실, 혼합현실, 홀로그램 등의 콘텐츠를 제작하는 데도 활용할 뿐만 아니라, 메타버스 역시 게임엔진으로 만든다. 게임엔진은 영상 편집 프로그램이 아니라 프로그래밍 도구에 가까우므로, 게임엔진을 잘 다루기 위해서는 3D 제작 도구와 C#, 자바 스크립트, C++ 등의 프로그래밍 언어가 필요하다. 이러한 이유로 현재 게임엔진을 활용한 영상 제작이 많은 수요가 있음에도 불구하고 인력 부족으로 많은 영상 콘텐츠가 나오지 못하고 있다.

게임엔진은 엄연히 하나의 제작 도구인 만큼 그 자체로 완성물을 가져오기는 힘들다. 가령 가상현실 콘텐츠를 만든다고 할 때, 첫 작업은 모션캡쳐를 통해 표정과 움직이는 모습 등을 촬영하는 것으로 시작한다. 모션캡쳐는 자연스러운 몸짓을 만들어내는 데 필요한 작업이다. <아바타>나 <혹성탈출>, <캣츠>와 같은 영화의 제작 영상을 보면, 가상의 캐릭터를 연기하는 배우의 얼굴과 몸에 무엇인가 잔뜩 부착된 것을 볼 수 있는데 이 장치를 통해 표정과 몸짓을 파악해 원본을 제작한다. 자연스러운 얼굴 모습과 몸짓을 구현했으니 이제 사람 모습이 필요한데, 바로 이 작업을 게임엔진으로 할 수 있다. 아직은 100% 사람의 모습과 똑같다고 말할 수는 없겠으나 매우 사실성이 뛰어나다. 무엇보다 중요한 것은 앞에서 말했듯이 실시간 작업이 가능하다는 것이다. 배우가 짓는 표정을 가상의 캐릭터가 그대로 실시간 구현을 하니 감독은 모니터를 보면서 실시간으로 확인할 수 있다. 출처: Unreal Engine(https://youtu.be/NW6mYurjYZ0)

출처: Unreal Engine(https://youtu.be/NW6mYurjYZ0)

최근 실사 동영상을 360도 모든 방향의 시점에서 구현하여 이를 영상으로 제공하거나 혼합현실 콘텐츠로 제공하는 볼류메트릭 영상(Volumetric video)을 만드는데도 유사한 방식으로 진행한다. 돔(Dome) 모양의 고정시설에 수십 대에서 수백 대의 카메라가 설치되어 배우의 움직임을 모두 담아내는데, 이를 고스란히 360도 영상으로 제공할 수 있다. 많은 카메라를 설치해야 하고, 카메라를 모두 동기화해야 하며, 실사의 형상이 왜곡되지 않도록 카메라 렌즈의 구성과 배치, 영상 처리 알고리즘을 잘 구성해야 한다. 한 대의 카메라로 렌더링을 할 때 드는 시간을 고려해보면, 수십 대 이상의 카메라로부터 추출하는 볼류메트릭 영상을 처리하기 위해 얼마나 고성능의 컴퓨터가 필요한지 가늠할 수 있을 것이다. 출처: Intel News(https://youtu.be/G0XUgnPl9KQ)

출처: Intel News(https://youtu.be/G0XUgnPl9KQ)

이렇게 게임엔진은 사용하기에 쉽지 않지만, 한 번 제작 시설을 구축해 놓으면 제작 플로우를 단축하고 단가, 시가 등을 줄이면서도 높은 품질의 영상을 제작할 수 있다는 장점이 있다. -

3프리비즈에서 영화까지, 한계를 뛰어넘다실감 미디어를 얘기한다고 해서 가상현실이나 혼합현실만 생각할 필요는 없다. 다시 말하지만, 실감 미디어와 실감 콘텐츠를 정의하는 것은 ‘와 진짜 같다!’라고 말하는 것처럼 실제의 경험을 하는 듯한 주관적 판단이기 때문이다. 그러면 실제로 게임엔진이 영상 산업에 어떻게 적용되는지 살펴보자.

게임엔진은 특히 영화를 찍을 때 사전 시각화를 의미하는 프리비즈(Pre-visualization) 작업에 최적화돼 있다. 프리비즈는 본격적인 작업에 들어가기 전에 시각효과 작업에 대해 정확한 계획을 세우고 점검하는 사전 작업을 말하는데 스토리보드의 역할을 한다고 생각하면 된다. 다만, 스토리보드는 흰 종이 위에 그림이 그려져 있다면 게임엔진은 HMD를 쓰고 실제처럼 꾸며진 3차원 공간을 직접 경험할 수 있다는 차이가 있다.

프리비즈를 잘 만들어야 실제 영상을 촬영하는 시간과 비용을 줄일 수 있다. 영화 <존 윅(John Wick: Chapter 3 - Parabellum, 2019)>의 경우 유리로 가득 찬 사무실에서의 격투 장면을 찍기 위해 무대 설치에만 수십억 원의 비용이 들었는데, 이 장면을 위해 제작자는 게임엔진으로 만든 가상현실로 디자인한 영화 세트를 만들었다. 배우들은 가상현실에서 충분히 움직임을 익힌 후 촬영에 임해 단 한 번의 촬영으로 유리로 가득 찬 사무실을 모두 깨부수며 성공적으로 영화 촬영을 마쳤다(정동훈, 2020.7월호). 만일 이러한 장면을 찍는데 사전에 정교하게 만들어진 가상현실 공간에서 연습하지 않았다면, 비싸게 만든 세트를 몇 번이나 다시 지어야 했거나 마음에 들지 않은 격투 장면을 그대로 썼을지도 모른다. 출처: Unreal Engine(https://youtu.be/ngudPwaAfIE)

출처: Unreal Engine(https://youtu.be/ngudPwaAfIE)

게임엔진으로 만든 콘텐츠는 사실성이 매우 뛰어나다. 게다가 작업을 더 빠르고 쉽게 만든다. 가령 영상의 남녀 주연 배우가 석양이 지는 산 위에서 고뇌하는 장면을 찍는다고 해보자. 이를 찍기 위해서는 두 명의 주인공과 그들의 코디네이터, 헤어 디자이너, 메이크업 디자이너 등 수십 명의 스태프가 함께 산에 올라야 할 것이다.

카메라와 음향 등 영상을 만들기 위한 모든 제작팀이 산에 올라가야 하는 것은 두말할 나위가 없다. 얼마나 많은 제작진이 함께 움직여야 하는지 그림이 그려진다. 그런데 아뿔싸, 기상예보를 믿고 산에 올라왔는데, 산 위의 날씨가 갑자기 변하는 것 아닌가? 고생고생해서 산 위를 올라왔지만, 오늘은 감독이 원하는 석양 장면을 찍을 수가 없다. 기껏 촬영을 위한 준비를 다 끝냈지만, 급변하는 산 정상의 날씨를 누가 예측할 수 있을까? 오늘은 어쩔 수 없이 하산하고, 내일 다시 오를 수밖에… 이러한 제작 환경은 영상촬영 중 일상다반사이다. 120분 길이의 영화를 찍기 위해 수개월의 촬영이 소요되는 이유가 바로 이 때문이다.

그러나 게임엔진을 활용한다면 조금 다른 이야기가 된다. 산 정상의 장면을 찍기 위해서는 카메라팀과 음향팀만 산에 오르면 되기 때문이다. 멋진 장면을 찍기 위해서 몇 날 며칠을 밤새우는 것은 이들로 족하다. 영상을 확보했으면 이후에는 가상 스튜디오(virtual studio)에서 모든 작업이 이루어진다. 배우가 위치한 뒤와 양옆의 공간은 LED 디스플레이를 설치해서 사전에 찍은 영상을 플레이하고, 배우가 위치한 곳은 마치 산 정상인 양 꾸미면 그만이다.

이후에는 평소 스튜디오 촬영처럼, 배우는 아무런 수고 없이, 오직 연기에만 집중하면 되는 것이다. 산을 오를 필요도, 석양을 기다릴 필요도 없고, 기상이변을 걱정할 필요도 없다. 감독은 원하지 않은 배경을 사전에 편집해서 가장 원하는 장면을 만들어 낼 수 있다. 최근 가상 스튜디오와 게임엔진이 만드는 영상 제작 변화의 모습이다. 출처: XON Studios(https://youtu.be/MCTs42p14LE)

출처: XON Studios(https://youtu.be/MCTs42p14LE) -

4진짜 같은 가짜 배우, 인간을 대체할까?에픽 게임즈는 2021년 2월에 새로운 소프트웨어 프로그램인 메타휴먼 크리에이터(Meta Human Creator)를 소개했는데, 이것을 이용해서 디지털 휴먼(Digital human)을 만들 수 있게 됐다. 메타휴먼, 디지털 휴먼, 사이버 휴먼(Cyber human), 버추얼 휴먼(Virtual human) 등 이름은 제각각이지만 정의는 유사하다(정동훈, 2021b). 실제 인간이 아닌 소프트웨어로 만든 가상의 인간이다. 물론 이제까지 소프트웨어로 만든 가상의 인간은 많이 있었다.

먼저 만화 캐릭터도 가상의 인간으로 볼 수 있다. 누구도 진짜 사람과 똑같이 생겼다고 생각하지는 않지만, 그 만화 캐릭터에 감정을 이입해서 볼 수 있으니 이것 역시 가상의 인간으로 볼 수 있다. 1998년에는 우리나라에서 최초의 사이버 가수가 등장했다. 아담이라는 이름으로 등장한 이 가수는 컴퓨터 그래픽으로 만든 캐릭터였다. 일본의 사이버 가수인 하츠네 미쿠는 전 세계적으로 가장 널리 알려져 있다. 이들은 진짜 같은 인간의 모습보다는 만화 캐릭터에 가까웠다.

최근 디지털 휴먼이 다시 관심을 받는 이유는 사실적인 구현에 있다. 즉 실제 인간과 구분하기가 어려울 정도로 똑같아진 것이다. 2021년 CES에서 LG전자는 새로운 시도를 했는데, 디지털 휴먼 김래아(Reah Keem)가 미디어 발표회에서 프레젠테이션을 맡았기 때문이다. LG전자는 음악가이자 DJ인 23세 여성 김래아에게 인공지능 기술을 적용해서 목소리와 움직임을 만들었다(LG전자 소셜홍보팀, 2021.01.08).

메타휴먼 크리에이터로 만든 디지털 휴먼은 사실성이 매우 뛰어나다. 입모양, 입이 움직일 때 얼굴 근육의 움직임, 말을 할 때 머리 부분이 미세하게 움직이는 것조차 신경을 쓰며 제작된다. 중요한 것은 이렇게 디지털 휴먼을 만드는 게 어렵지 않다는 것이다. 클릭 하나로 헤어스타일과 수염, 주름, 나이대 등 눈, 얼굴, 몸 등 모든 것을 마음대로 바꿀 수 있으니 똑같이 생긴 디지털 휴먼은 존재하지 않게 된다. 수십 수백만 명의 디지털 휴먼을 만든다고 해도 모두 다른 생김새를 지닌 디지털 휴먼으로 창조할 수 있는 세상이 된 것이다. 출처: 김래아 인스타그램(https://www.instagram.com/reahkeem/)

출처: 김래아 인스타그램(https://www.instagram.com/reahkeem/)

메타버스 제작 역시 다르지 않다. 엔비디아, 어도비, 오토데스크, 유니티, 언리얼 엔진 등 메타버스로 일컫는 가상 세계를 만들 수 있는 소프트웨어를 통해 사실감을 극대화하며 현실과 같은 물리법칙이 적용된 가상의 공간을 만들고 있다. 이러한 공간에 메타휴먼 크리에이터로 만든 에이전트인 디지털 휴먼이 돌아다니고, 인간과 상호작용하며 무언가를 하는 시대가 온다는 것은 자연스러운 미래 예측이 아닐까?

이러한 세상이 되면 진짜 사람과 가짜 사람의 구분이 무슨 의미가 있을까? 김래아처럼 인공지능으로 목소리를 입히고, 진짜 같은 몸짓을 하게 만든다면, 게다가 내가 좋아하는 이상형으로 만들어진다면, 가상세계에서의 인간관계는 현실과 같이 진보할 것이고, 이러한 관계가 현실과 최대한 유사해질수록 메타버스의 성공 확률은 그만큼 높아질 것이다. 출처: Unreal Engine(https://youtu.be/S3F1vZYpH8c)

출처: Unreal Engine(https://youtu.be/S3F1vZYpH8c)

가짜는 아니지만, 2020년 CJ ENM의 엠넷 아시안 뮤직 어워드(MAMA) 공연에서 활용한 영상 합성 기술이 전 세계의 주목을 받은 바 있다. 당시 방탄소년단(BTS)의 멤버 슈가가 어깨 수술로 인해 불참한 채 공연을 했는데, 마지막 곡 ‘LIFE GOES ON’을 부를 때 슈가가 갑자기 나타나서 시청자를 깜짝 놀라게 했다. 이것 역시 볼류매트릭과 언리얼 엔진을 통해 사전 제작한 슈가의 영상을 공연 영상에 합성해 만든 것인데, 합성한 티가 거의 나지 않아 깜짝 놀랐다는 시청자들의 반응이 넘쳐났다. 게임엔진의 사실성은 이전의 영상 편집과는 비교가 되지 않을 정도로 정교하다. 이처럼 게임엔진을 활용한 다양한 영상 제작 방식은 ‘실감나는’ 경험을 주기에 충분하다. -

5마치며미디어 산업은 늘 변화와 혁신의 연속이다. OTT, 인공지능, 유튜브, 소셜 미디어, 메타버스 등 미디어 산업이 당면한 새로운 도전은 사용자 관점에서는 흥분을, 종사자 관점에서는 두려움을 자아낸다. 이 글을 마치며 미디어 업계의 디지털 트랜스포메이션을 준비하기 위한 단 하나의 기술적 요소를 뽑으라고 한다면 리얼타임 렌더링, 즉 게임엔진을 꼽는 데 주저함이 없다. 미디어 산업 진흥을 위해서는 민관이 함께 게임엔진에 대한 인력 확충과 재교육에 더욱 신경을 써야 한다. 무엇보다도 인력의 확충이 시급하다. 리얼타임 렌더링을 다룰 수 있는 인력의 부족은 당분간 계속될 것이다. 앞에서 말했듯이, 리얼타임 렌더링의 수요는 시각화와 관련된 모든 업종에서 급격하게 증가하고 있다. 특히 게임업계에서 높은 급여를 무기로 이들을 채용하고 있는 상황에서, 미디어 업계의 게임엔진 전문가는 거의 찾아보기 힘들다.

대학에서는 게임엔진을 전문으로 다루는 학과가 없다. 소프트웨어 전공 학과에서는 게임엔진을 프로그래밍이라기보다는 하나의 소프트웨어로 보기 때문에 정규과정에서 다루지 않는다. 방송, 영상, 콘텐츠를 다루는 미디어커뮤니케이션학과에서는 여전히 편집 프로그램만 가르치고 있을 뿐이다. 심지어 리얼타임 렌더링에 대한 이해도도 낮다. 인력 공급이 충분히 이루어질 수 없는 조건이다.

현재 영상 관련 업계 종사자는 리얼타임 렌더링에 대한 재교육을 통해 새로운 전환을 준비해야 한다. 가령, 버추얼 스튜디오 촬영이 지속해서 증가할 것으로 예측하는데, 이를 위해서는 전혀 새로운 팀 구성이 필요하다. 프로덕션사의 촬영감독과 현장 프로듀서처럼 이전부터 필요했던 인력도 있지만, 버추얼스튜디오 수퍼바이저, LED 관리자, 미디어 서버 관리자, 게임엔진 테크니션 등 새로운 인력의 충원도 필요하다. 현재 컴퓨터 그래픽 작업을 하는 인력 중 게임엔진 테크니션으로 전환하는 것은 좋은 대안일 수 있다. 가상현실, 메타버스 등 영상업계의 디지털 트랜스포메이션을 막연히 두려워하기보다는 미래를 준비하는 시발점을 리얼타임 렌더링으로 삼아 관심과 투자를 증가시키기를 바란다. -

Reference

- 정동훈. (2017). 가상현실에 관한 사용자 관점의 이론과 실제. <정보화정책>, 24권 1호, 3-29.

- 정동훈 (2020). <미디어, 너 때는 말이야>. 서울: 넥서스

- 정동훈 (2020.7월호). 유니티·언리얼엔진. 진짜보다 더 진짜 같은 현실 만드는 게임 기술, 게임 넘어 미디어 영역 넘본다.<신문과 방송>, 80-85

- 정동훈 (2021a). <가상현실, 너 때는 말이야>. 서울: 넥서스

- 정동훈 (2021b). <인공지능, 너 때는 말이야>. 서울: 넥서스

- LG전자 소셜홍보팀(2021.01.08). 글로벌 무대 데뷔하는 버추얼 인플루언서, 래아(Reah). URL: https://live.lge.co.kr/virtual_influencer_reah/